SISTEMAS EXPERTOS

Un sistema experto o un sistema de conocimiento basado en reglas de

inferencias es un conjunto de programas que pueda acceder a una gran

masa de informaciones donde se reune las experiencias y conocimietos de

uno o maas expertos en un determinado campo de la ciencia o de la

tecnica para la resolicion de problemas.

UTILIZACION DEL LENGUAJE NATURAL

Las aplicaciones utilizan el lenguaje natural (natural language

processing-NLP)Realizan procesos que reciben los datos de entrada en

lenguaje natural entendiendo como tal un lenguaje escrito o hablado en

un determinado idioma y acontinuacion los procesan, produciendose la

salida tambienen lenguaje natural.

Un programa de reconocimiento de lenguaje natural consta de una base de

conocimientos que contienen un diccionario completo de palabras del

idioma del donde el objetivo del programa es el reconocimiento de las

mismas para provocar las reacciones correspondientes a cada

reconocimiento.

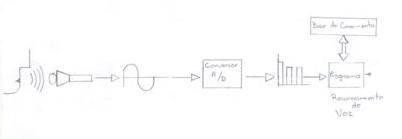

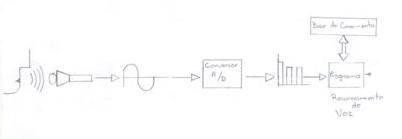

RECONOCIMIENTO DE LA VOZ

Las aplicaciones del reconocimiento de la voz tiene como

objetivo la captura, por parte de una computadora de la voz humana bien

para el tratamiento de lenguage natural para cualquier tipo de funcion

En primer lugar, la voz se calcula electronicamente con un microfono

que genera una señal analogica, para a continuacion convertirla

en una señal digital que pueda alimentar a un programa

inteligente capaz de interpretarla con exactutud. en este caso la base

de conocimiento contiene los patrones para que los programas puedan

realizar las comparaciones y se produzca el reconocimiento.

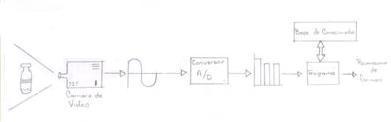

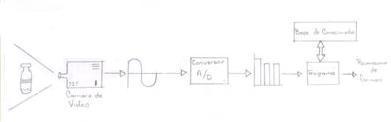

RECONOCIMIENTO DE FORMAS

Las aplicaciones de reconocimiento de formas trata de imitar la

vision humana a traves de la captacion de una imagen por medio de una

camara de video. Esta imagen produce una señal analogica que

posteriormente se digitaliza yacontinuacion se procesa por medio de un

programa inteligente que realiza las correspondientes comparaciones con

los patrones obtenidos en la base de conocimientos hasta conseguir el

reconocimiento.

ROBOTICA

Los robots son dispositivos compuestos de censores que reciben datos de

entrada y que pueden estar conectados a la computadora. Esta, al

recibir la información de entrada, ordena al robot que

efectúe una determinada acción. Puede ser que los propios

robots dispongan de microprocesadores que reciben el input de los

sensores y que estos microprocesadores ordenen al robot la

ejecución de las acciones para las cuales está concebido.

En este último caso, el propio robot es a su vez una

computadora.

Tipos de robots

Robots impulsados neumaticamente: La programación consiste en la

conexión de tubos de plástico a unos manguitos de

unión de la unidad de control neumático. Esta unidad

está formada por dos partes: una superior y una inferior. La

parte inferior es un secuenciador que proporciona presión y

vacío al conjunto de manguitos de unión en una secuencia

controlada por el tiempo. La parte superior es el conjunto de manguitos

de unión que activan cada una de las piezas móviles del

robot. Son los más simples que existen. Hay quien opina que a

este tipo de máquinas no se les debería llamar robots;

sin embargo, en ellas se encuentran todos los elementos básicos

de un robot: estas máquinas son programables, automáticas

y pueden realizar gran variedad de movimientos.

Futuro de la robótica

A pesar de que existen muchos robots que efectúan trabajos

industriales, aquellos son incapaces de desarrollar la mayoría de

operaciones que la industria requiere. Al no disponer de unas

capacidades sensoriales bien desarrolladas, el robot es incapaz de

realizar tareas que dependen del resultado de otra anterior.

En un futuro próximo, la robótica puede

experimentar un avance espectacular con las cámaras de

televisión, más pequeñas y menos caras, y con las

computadoras potentes y más asequibles.

Los sensores se diseñarán de modo que puedan medir

el espacio tridimensional que rodea al robot, así como reconocer

y medir la posición y la orientación de los objetos y sus

relaciones con el espacio. Se dispondrá de un sistema de proceso

sensorial capaz de analizar e interpretar los datos generados por los

sensores, así como de compararlos con un modelo para detectar

los errores que se puedan producir. Finalmente, habrá un sistema

de control que podrá aceptar comandos de alto nivel y

convertirlos en órdenes, que serán ejecutadas por el

robot para realizar tareas enormemente sofisticadas.

Redes Neuronales.

Las Redes Neuronales surgieron del movimiento conexionista, que

nació junto con la Inteligencia Artificial simbólica o

tradicional. Esto fue hacia los años 50, con algunos de los

primeros ordenadores de la época y las posibilidades que

ofrecían.

La Inteligencia Artificial simbólica se basa en que todo

conocimiento se puede representar mediante combinaciones de

símbolos, derivadas de otras combinaciones que representan

verdades incuestionables o axiomas.

Así pues, la Inteligencia Artificial tradicional asume que el

conocimiento es independiente de la estructura que maneje los

símbolos, siempre y cuando la 'máquina' realice algunas

operaciones básicas entre ellos. En contraposición, los

'conexionistas' intentan representar el conocimiento desde el estrato

más básico de la inteligencia:

ESTRATO FISICO.

Creen que el secreto para el aprendizaje y el conocimiento se halla

directamente relacionado con la estructura del cerebro: concretamente

con las neuronas y la interconexión entre ellas. Trabajan con

grupos de neuronas artificiales, llamadas Redes Neuronales.

La estructura

básica

de una neurona natural es:

Éstas funcionan

como sigue:

Cada neurona puede tener

infinitas entradas llamadas Dendritas que condicionan el estado de su

única salida, el Axón. Este Axón puede ir

conectado a una Dendrita de otra neurona mediante la Sinapsis

correspondiente, de la siguiente manera:

El Axón da un

nivel eléctrico correspondiente a sus entradas y a la

importancia que les da a cada una de ellas. De esta forma, una

neurona puede no reaccionar ante un nivel muy alto de una de sus

entradas, o dar una salida muy favorable cuando otra de ellas

está

mínimamente activa.

En las primeras etapas

de nuestra vida, cuando realizamos el aprendizaje de nuestros

cerebros, entrenamos nuestras neuronas mediante el éxito o

fracaso de una acción a unos estímulos sensoriales.

Cuando cierta

acción

realizada en respuesta a alguna entrada sensorial es exitosa (por

ejemplo, al beber agua calmamos la sed), las conexiones

sinápticas

entre un grupo de neuronas se fortalecen, de manera que cuando

tengamos una sensación sensorial parecida, la salida será

la correcta. De esta forma se forman fuertes conexiones entre grupos

de neuronas, que pueden servir para realizar otras acciones

complejas.

El esquema de una

neurona artificial es:

Esta neurona funciona

de la siguiente manera:

cada entrada x tiene

su

peso asociado w, que le dará más o menos importancia en

la activación de la neurona. Internamente se calcula la suma

de cada entrada multiplicada por su peso:

Con este valor de

suma

ponderada se calcula una función de activación, que

será la salida que dará la neurona. Las dos funciones

de activación más usada son el Escalón y la

Sigmoidea:

Principalmente se diferencian en que la Sigmoidea (llamada así

por su forma de S) es diferenciable en todos sus puntos y la

Escalón no.

El Perceptrón unicapa.

Un Perceptrón unicapa no es más que un conjunto de

neuronas no unidas entre sí, de manera que cada una de las

entradas del sistema se conectan a cada neurona, produciendo cada una

de ellas su salida individual:

Como se ha dicho, un conjunto de neuronas no sirve para nada

si

previamente no se le enseña qué debe hacer.

Existen tres métodos de aprendizaje para un

Perceptrón:

Supervisado, Por Refuerzo y No Supervisado.

Principalmente se

diferencian en que la Sigmoidea (llamada así por su forma de

S) es diferenciable en todos sus puntos y la Escalón no.

El Perceptrón

unicapa.

Un Perceptrón

unicapa no es más que un conjunto de neuronas no unidas entre

sí, de manera que cada una de las entradas del sistema se

conectan a cada neurona, produciendo cada una de ellas su salida

individual:

Como se ha dicho, un

conjunto de neuronas no sirve para nada si previamente no se le

enseña qué debe hacer.

Existen tres

métodos

de aprendizaje para un Perceptrón: Supervisado, Por Refuerzo y

No Supervisado.

El Perceptrón multicapa

Nacio con la

intension de dar solucion a las limitaciones del perseptrón

clasico o unicapa y supuso el resurgimiento del movimiento

conexionista. Se trate de unos cuantos (2 o 3 ) perseptrones unicapa

conectados en cascada.

Un ejemplo prectico

de un perceptrón multicapa podria ser su uso en vision

artificial. Dada su capacidad para generalizar las redes neuronales ya

han demostrado su importancia en este campo.

Se puede saber que la

red aprenda 2 o 3 formas basicas y quedada otra que no ha aprendido, la

clasifique como la mas cercana a las que conoce y ademas de un

porcentaje de lo segura que estaque esa nueva forma se paresca a una

que ha aprendido.

Sistemas

Expertos

¿Qué

es un sistemas experto?

Los sistemas expertos forman parte de un firme y verdadero avance

en inteligencia artificial. Los sistemas expertos pueden incorporar

miles de reglas. Para una persona seria una experiencia casi

"traumática" el realizar una búsqueda de reglas posibles

al completado de un problema y concordar estas con las posibles

consecuencias, mientras que se sigue en un papel los trazos de un

árbol de búsqueda. Los sistemas expertos realizan

amablemente esta tarea; mientras que la persona responde a las

preguntas formuladas por el sistema experto, este busca recorriendo las

ramas más interesantes del árbol, hasta dar con la

respuesta a fín al problema, o en su falta, la más

parecida a esta. Los sistemas expertos tienen la ventaja frente a otro

tipos de programas de Inteligencia Artificial, de proporcionar gran

flexibilidad a la hora de incorporar nuevos conocimientos. Para ello

solo tenemos que introducir la nueva regla que deseemos hacer constar y

a está, sin necesidad de cambiar el funcionamiento propio del

programa. Los sistemas expertos son "auto explicativo", al contrario

que en los programas convencionales, en los que el conocimiento como

tal está encriptado junto al propio programa en forma de

lenguaje de ordenador. Los expertos de I.A. dicen que los sistemas

expertos tienen un conocimiento declarativo, mientras que en los

demás programas es procedural.

HISTORIA DE LOS (SE)

Sus inicios datan a mediados de los años sesenta. Durante esta

década los investigadores Alan Newell y Herbert Simon

desarrollaron un programa llamado GPS (General Problem Solver;

solucionador general de problemas). Podía trabajar con

criptoaritmética, con las torres de Hanoi y con otros problemas

similares. Lo que no podía hacer el GPS era resolver problemas

del mundo real, tales como un diagnóstico médico.

Algunos investigadores decidieron entonces cambiar por completo el

enfoque del problema restringiendo su ambición a un dominio

específico e intentando simular el razonamiento de un experto

humano. En vez de dedicarse a computarizar la inteligencia general, se

centraron en dominios de conocimiento muy concretos. De esta manera

nacieron los SE.

A partir de 1965, un equipo dirigido por Edward Feigenbaum,

comenzó a desarrollar SE utilizando bases de conocimiento

definidas minuciosamente. Dos años

más tarde se construye DENDRAL, el cual es considerado como el

primer SE. La ficción de dicho SE era identificar estructuras

químicas moleculares a partir de su análisis

espectrográfico.

En la década de los setenta se desarrolló MYCIN para

consulta y diagnóstico de infecciones de la sangre. Este sistema

introdujo nuevas características: utilización de

conocimiento impreciso para razonar y posibilidad de explicar el

proceso de razonamiento. Lo más importante es que funcionaba de

manera correcta, dando conclusiones análogas a las que un ser

humano daría tras largos años de experiencia. En MYCIN

aparecen claramente diferenciados motor de inferencia y base de

conocimientos. Al separar esas dos partes, se puede considerar el motor

de inferencias aisladamente. Esto da como resultado un sistema

vacío o shell (concha). Así surgió EMYCIN (MYCIN

Esencial) con el que se construyó SACON, utilizado para

estructuras de ingeniería, PUFF para estudiar la función

pulmonar y GUIDON para elegir tratamientos terapéuticos.

En esa época se desarrollaron también: HERSAY, que

intentaba identificar la palabra hablada, y PROSPECTOR, utilizado para

hallar yacimientos de minerales. De este último derivó el

shell KAS (Knowledge Adquisition System).

En la década de los ochenta se ponen de moda los SE,

numerosas

empresas de alta tecnología investigan en este área de la

inteligencia artificial, desarrollando SE para su

comercialización. Se llega a la conclusión de que el

éxito de un SE depende casi exclusivamente de la calidad de su

base de conocimiento. El inconveniente es que codificar la pericia de

un experto humano puede resultar difícil, largo y laborioso.